成人电影 我院科研服从新动态(四)——ECCV书籍

ECCV 2024近日放榜,南京大学智能科学与技能学院七项使命被委派。ECCV (欧洲议论机视觉会议成人电影,European Conference on Computer Vision)是国外议论机视觉与花式识别边界的三大顶级会议之一,本年9月份将介意大利米兰举行。

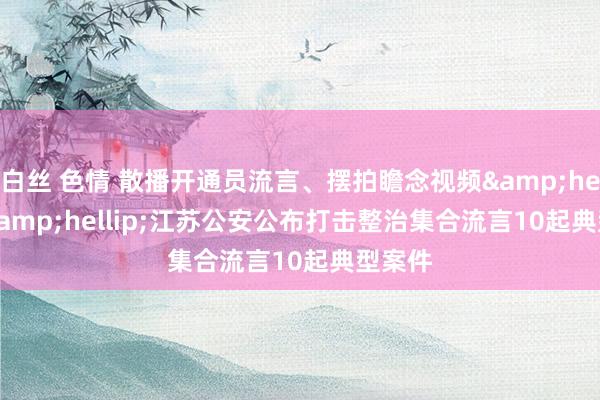

使命一:Jiajun Hu, Jian Zhang, Lei Qi, Yinghuan Shi and Yang Gao. Learn to Preserve and Diversify: Parameter-Efficient Group with Orthogonal Regularization for Domain Generalization. In European Conference on Computer Vision (ECCV), 2024.

名堂主页:https://github.com/JudgingH/PEGO

频年来,由于其海量的参数及弘大的张望数据集,基础模子已在多项任务上展现出色的泛化武艺。但是,课题组夺目到当平直将基础模子用于具有较大分散相反的边界泛化任务时,基础模子的泛化性能反而比拟成例小模子更低。针对此问题,课题组对微调后的基础模子的泛化武艺进行商讨,调研了近期热点的参数高效微调技能,通过所遐想的正交正则化耗费对其进行分析更正,有用晋升了模子的分散外泛化武艺。

具体地,提倡将一组参数高效的低秩安妥模块注入到预张望基础模子中,并左右所提倡的正交正则化耗费来增强模子的泛化武艺。该顺序有用地保留了预张望模子的泛化武艺并促使模子学习到更为各种化的常识,扼制了模子关于源域数据的过拟合。论文在五个常见边界泛化基准数据集上进行了多项对比实验和消融实验,比拟于多种类型的基线顺序得回了最高的平均准确率。此外,论文顺序不错应用于任何含有线性层的神经汇集,同期关于张望支拨是友好的,且无需增多特地的测试资本。

使命二:Muyang Qiu, Jian Zhang, Lei Qi, Qian Yu, Yinghuan Shi, Yang Gao. The Devil is in the Statistics: Mitigating and Exploiting Statistics Difference for Generalizable Semi-supervised Medical Image Segmentation. In European Conference on Computer Vision (ECCV), 2024.

名堂主页:https://github.com/qiumuyang/SIAB

多中心可泛化的医学图像分割旨在热心怎样提高分割模子在不同医疗机构、缔造和患者群体上的泛化武艺。但是,传统医疗图像分割边界泛化顺序需要对多个边界的张望数据一齐进行像素级标注,例必会引入较高的标注资本。因此,论文热心近期提倡的医疗图像半监督边界泛化问题,左右汇集于不同边界的少许有标注和渊博无标注数据,在减少标注量的同期,提高分割模子的泛化武艺。

具体地,该使命在一致性正则化的半监督张望范式下,提倡了一种基于归一化层统计量孤独和团员的多分支结构,以提高边界偏移影响下的伪标签质地。此外,论文通过灰度直方图匹配和就地经受归一化分支以模拟边界分散相反,构造特地的图像和特征级别一致性正则化贬抑项,丰富张望阶段模子所见分散,进一步晋升模子的泛化武艺。所提倡顺序在多个多中心医疗图像分割数据集上进行考证,比拟较当今该边界的最新顺序,均得回较好扫尾。

使命三:STAG4D: 基于时空锚定的生成式4D高斯泼溅

最近,在预张望扩散模子和3D生成方面的解析引发了东说念主们对4D本色创作的兴趣。但是,结束具有空间-时分一致性的高保真4D生成仍然是一项挑战。针对这个挑战,南京大学智能科学与技能学院三维视觉实验室(NJU-3DV)提倡了STAG4D,这是一个新颖的框架,它联接了预张望的扩散模子和动态3D高斯泼溅技能,用于高保真4D生成。鉴戒3D生成技能,咱们使用多视图扩散模子来启动化锚定在输入视频帧上的多视图图像成人电影,其中视频输入既不错是履行全国拿获的,也不错是由视频扩散模子生成的。

具体来说,为了确保多视图序列启动化的时分一致性,咱们引入了一个浅易但有用的夺宗旨交融政策,咱们在自夺宗旨议论中使用第一帧行为时分锚定。通过这种政策生成了确切一致的多视图序列之后,咱们应用得分蒸馏采样来优化4D高斯点云。与此同期,咱们提倡了一种自安妥密集化政策,以缩小不踏实的4D高斯泼溅张望梯度,以结束持重的优化过程。值得夺办法是,所提倡的进程不需要对扩散汇集进行任何预张望或微调,为4D生成任务提供了一个更实用的责罚决策。平庸的实验标明,咱们的顺序在渲染质地、空间-时分一致性和生成持重性方面优于之前的4D生成使命,为包括文本、图像和视频在内的各种化输入设定了新的4D生成的最高水平。该使命仍是被议论机视觉顶级会议ECCV 2024 袭取。

图:STAG4D算法结构透露图

使命四:CHAMP:三维姿态驱动的东说念主物动画合成

在东说念主物跳舞视频生成任务中,当今的主流顺序通过骨架序列视频行为适度信号。但是,这类浅易的二维适度信号存在耀眼,跳变等问题,在抒发复杂动作时存在较大辛苦。针对这些问题,南京大学智能科学与技能学院三维视觉实验室(NJU-3DV)连合复旦大学生成式视觉实验室探索了将三维信息引入跳舞视频生成任务,左右SMPL三维东说念主体模子提供具有高度一致性的三维适度信号,并提倡相应责罚算法CHAMP。

具体而言,CHAMP算法凭据驱动视频,预测出驱动视频中东说念主物的SMPL参数序列,渲染成深度、法线、语义信息图等三维适度信号,联接二维骨架信息,连合输入适度信号编码器,提供了丰富且具有高度一致性的适度信息。联接参考汇集和清醒信息模块,结束了可控且一致的东说念主物跳舞视频生成。实验扫尾标明,CHAMP算法在多个公开数据集上的效果彰着优于对比算法,考证了其有用性。该使命已被议论机视觉顶级会议ECCV 2024袭取。

图:CHAMP算法透露图

使命五:Head360:高保真全角度三维头部生成与驱动

创建一个360度可渲染的三维数字东说念主头部模子是一项颠倒具有挑战性的任务。尽管此前的商讨使命仍是展示了左右假造合成数据构建这种参数化东说念主头模子的有用性,但三维头部建模的宽视角渲染、色调驱动和外貌剪辑等方面的性能仍然不及。南京大学智能科学与技能学院三维视觉实验室(NJU-3DV)针对此任务,提倡在数目有限的高精度三维模子数据的基础之上,张望出360度可渲染的数字东说念主头部参数化模子。该模子将面部清醒、外形和外貌解耦,离别由参数化三维网格模子和神经纹理透露,同期提倡了一种新式张望顺序,用于剖析头发和面部外貌,补助发型的摆脱更换。

具体而言,所提倡的参数化头部模子由一个六平面神经发射场透露,以生成神经纹理和参数化的三维网格模子为条款输入。该模子将面部外不雅、时势和清醒离别参数化为纹理编码、时势编码和色调基参数,结束了基于单张图像输入的高质地三维模子拟合。所提倡的模子是第一个补助360度摆脱视角合成、图像拟合和色调驱动的头部参数化模子,实验扫尾标明,该模子在参数空间中结束了面部清醒和外貌的精准解耦,在渲染和驱动质场所面达到了三维数字东说念主头部建模的最高水平。该使命仍是被议论机视觉边界顶级会议ECCV 2024 袭取。

图:Head360算法结构透露图

使命六:基于材质剖析和光芒追踪的高斯点云信得过感重光照技能

三维高斯溅射技能因其高效的优化服从、高质地的渲染质地和快速的渲染速率,在新视角合成和三维重建边界引发了一场商讨高潮。但是,现存的三维高斯点云霄达尚不补助重光照这一进攻应用。针对这一问题,南京大学智能科学与技能学院三维视觉实验室(NJU-3DV)提倡了一种基于材质剖析和光芒追踪的高斯点云信得过感重光照技能,以结束相片级信得过的重光照效果。

具体而言,该技能在原始三维高斯点云霄达之上添加法向量、BRDF参数以及入射光等属性,赋予三维高斯点云可重光照的特质。从多视图影像动身,该技能通过三维高斯喷溅 (3D Gaussian Splatting, 3DGS) 技能优化三维场景,同期通过基于物理的可微渲染剖析BRDF和光照。为了在重光照中生成合理的暗影效果,该技能还改造性地在龙套点云霄征上遐想了一种光芒追踪顺序,联接端倪包围体(Bounding Volume Hierarchies, BVH) 结构进行高效的可见性展望算。实验标明,与发轫进的顺序比拟,该技能在BRDF意象、新视图合成和重光照扫尾方面有显耀晋升。所提倡的框架展示了基于点云的渲染在剪辑、光芒追踪和重光照上的巨大后劲。该使命仍是被国外议论机视觉顶级会议 ECCV2024 袭取。

图:基于三维高斯点云霄达的多物体组合场景重光照

图:基于三维高斯点云霄达的信得过场景重光照

使命七:EmoTalk3D:热情可控的高保真摆脱视角话语动画合成

3D Talking Head生成是指凭据输入语音合成一个东说念主话语的三维动画,其中枢挑战在于将语音尘号准确地映射到嘴唇清醒、面部色融合三维外形上。尽管渊博商讨使命尝试3D Talking Head生成任务,此前的顺序在渲染质地、音唇同步性和多视点一致性等方面仍存在问题。此外,先前的商讨顺序一样惨酷了数字东说念主的热情抒发,缩短了合成视频的信得过感。针对这些挑战,南京大学智能科学与技能学院三维视觉实验室(NJU-3DV)提倡了一种高保果然热情可控的3D Talking Head生成顺序。团队构建了首个包含语音、热情标注、逐帧多视点视频及三维模子的数据集—EmoTalk3D数据集,并基于该数据集提倡了基于“语音-几何-外貌”的新式数字东说念主驱动框架。

该顺序领先凭据音频特征预测出准确的三维模子序列,此后凭据预测的几何信息合成以4D高斯为表征的东说念主物动态外貌。其中,东说念主物外貌被进一步剖析为基准高斯重量和动态高斯重量,并凭据多视点视频信息优化,结束了可摆脱视角渲染的3D Talking Head模子。此外,通过从输入语音中索取热情标签,结束了3D Talking Head的热情可控性。该顺序呈现出较高的渲染质地、踏实的唇音同步性、明晰的动态面部细节及准确活泼的热情抒发,实验扫尾考证了该顺序在热情可控的东说念主物话语视频生成上的有用性。该使命仍是被议论机视觉顶级会议ECCV 2024袭取。

图:EmoTalk3D算法结构透露图